Serwery firmowe: 10 lat temu, 5 lat temu i dziś – jak bardzo się zmieniło?

Dziesięć lat temu serwer w firmie to była najczęściej jedna fizyczna maszyna stojąca w serwerowni lub nawet w biurze. Obsługiwała system ERP, kontrolę dostępu, ewentualnie czas pracy i udostępnianie plików. Miała kilka rdzeni procesora, może 16–32 GB RAM-u i dyski HDD. Dla większości firm to było wystarczające – bo i wymagania były inne.

Dziś ta sama firma może mieć dwa razy więcej pracowników, pracę hybrydową, dostęp zdalny do systemów, integracje z dostawcami i klientami, monitoring produkcji w czasie rzeczywistym, system zarządzania budynkiem podłączony do sieci, backup w chmurze i wymagania bezpieczeństwa na poziomie, o którym dziesięć lat temu się nie mówiło. A serwer? Często wciąż ten sam. Albo jego „odświeżona" wersja, która została dobrana pod potrzeby sprzed pięciu lat – a od tego czasu firma znowu urosła.

Co się zmieniło w technologii serwerów?

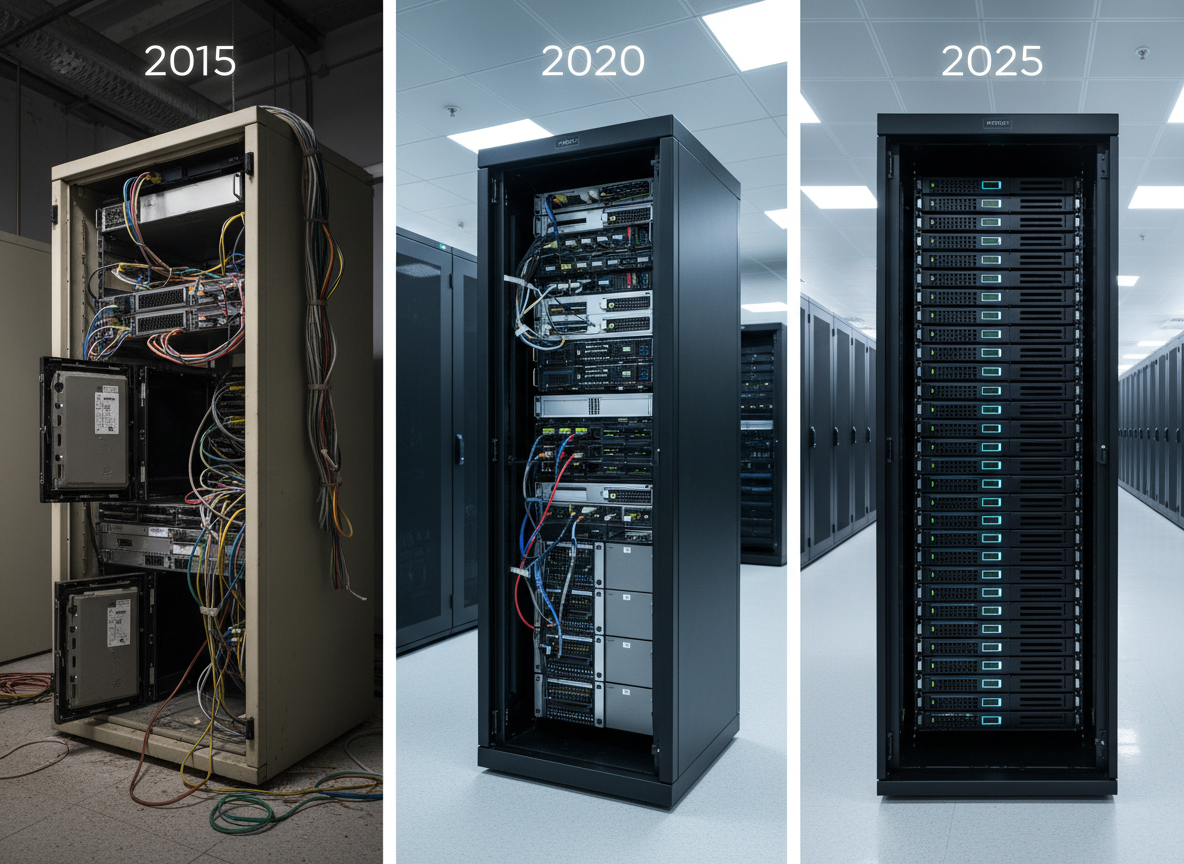

Dziesięć lat temu:Serwery miały procesory z kilkoma rdzeniami (4–8), dyski HDD o pojemności 1–2 TB, pamięć RAM rzędu 16–32 GB. Wirtualizacja była „nowością", o której słyszało się głównie w dużych korporacjach. Większość firm stawiała jeden fizyczny serwer na jedno zadanie: jeden pod ERP, drugi pod pliki, trzeci pod backup. Zużycie energii było wysokie, chłodzenie kosztowne, a zarządzanie czasochłonne.

Pięć lat temu:Procesory miały już 8–16 rdzeni, pojawiły się dyski SSD jako standard dla systemów operacyjnych i baz danych, a pamięć RAM wzrosła do 64–128 GB. Wirtualizacja stała się normą – jedna fizyczna maszyna mogła obsługiwać kilka wirtualnych serwerów. To oznaczało lepsze wykorzystanie zasobów, mniejsze zużycie prądu i łatwiejsze zarządzanie. Backup zaczął migrować do chmury, a firmy zaczęły mówić o „high availability" i redundancji.

Dziś:Nowoczesne serwery mają procesory z 16–64 rdzeniami (a w segmencie enterprise nawet więcej), pamięć RAM od 128 GB do kilku TB, pełne macierze SSD NVMe o wydajności wielokrotnie wyższej niż najszybsze dyski HDD sprzed dekady. Wirtualizacja to standard, a coraz więcej firm przechodzi na infrastrukturę hiperkonwergentną (HCI), która łączy compute, storage i sieć w jednym, łatwo skalowalnym rozwiązaniu. Zużycie energii na jednostkę mocy obliczeniowej spadło dramatycznie – dzisiejszy serwer przy tej samej lub niższej mocy zużywa mniej prądu i generuje mniej ciepła niż jego poprzednik sprzed dekady, a jednocześnie jest wielokrotnie wydajniejszy.

Jak zmieniły się potrzeby firm?

Dziesięć lat temu firma produkcyjna miała system ERP, kontrolę dostępu i może system czasu pracy. Dziś ta sama firma ma:

- ERP zintegrowany z e-commerce, magazynem i dostawcami,

- system MES (Manufacturing Execution System) monitorujący produkcję w czasie rzeczywistym,

- system zarządzania budynkiem (BMS) kontrolujący oświetlenie, klimatyzację, monitoring,

- kontrolę dostępu zintegrowaną z systemem HR i czasem pracy,

- backup lokalny i w chmurze,

- monitoring infrastruktury IT,

- zdalny dostęp dla pracowników hybrydowych,

- wymagania bezpieczeństwa (segmentacja sieci, firewall, antywirusy, polityki dostępu),

- compliance z RODO, ISO, branżowymi regulacjami.

To wszystko generuje wielokrotnie większe obciążenie serwerów niż kiedykolwiek wcześniej. A jeśli infrastruktura nie nadąża, pojawiają się problemy: spowolnienia systemów, przestoje, brak możliwości dodania nowych funkcji, rosnące koszty utrzymania przestarzałego sprzętu.

Na co zwracać uwagę przy ocenie obecnej infrastruktury?

Wiek sprzętu:Serwery starsze niż 5–7 lat są już zazwyczaj poza okresem wsparcia producenta. To oznacza brak aktualizacji firmware, brak części zamiennych, rosnące ryzyko awarii i brak gwarancji.

Zużycie zasobów:Jeśli procesory pracują stale powyżej 70–80% obciążenia, pamięć RAM jest zapełniona, a dyski są pełne lub wolne – to znak, że infrastruktura jest na granicy wydolności. Każdy nowy system, integracja czy użytkownik pogarsza sytuację.

Koszty energii i chłodzenia:Stare serwery zużywają nieproporcjonalnie dużo prądu w stosunku do mocy obliczeniowej. Wymiana na nowoczesny sprzęt często zwraca się w 2–3 lata tylko z oszczędności na energii.

Brak redundancji i backupu:Jeśli awaria jednego serwera zatrzymuje całą firmę, a backup jest „gdzieś na dysku", to ryzyko jest ogromne. Nowoczesna infrastruktura powinna mieć redundancję (zapasowe komponenty, klastry, replikację) i sprawdzony, regularnie testowany backup.

Skalowalność:Czy dodanie nowego systemu, użytkowników lub lokalizacji wymaga wymiany całej infrastruktury, czy można ją rozbudować modułowo? Nowoczesne rozwiązania (wirtualizacja, HCI, chmura hybrydowa) dają elastyczność, której brakowało starszym architekturom.

Co to oznacza dla Twojej firmy?

Jeśli Twoja firma korzysta z serwerów dobranych 5–10 lat temu, a od tego czasu:

- zatrudniłeś więcej ludzi,

- wdrożyłeś nowe systemy (MES, BMS, integracje),

- zacząłeś pracę hybrydową lub zdalną,

- pojawiły się nowe wymagania bezpieczeństwa i compliance,

to jest bardzo prawdopodobne, że Twoja infrastruktura już nie odpowiada aktualnym potrzebom. Może działać „jakoś", ale kosztem:

- wolniejszej pracy systemów,

- wyższego ryzyka awarii,

- wyższych kosztów energii i utrzymania,

- braku możliwości rozwoju (bo „serwer już nie udźwignie kolejnego systemu").

Darmowa analiza infrastruktury – sprawdź, czy Twoje serwery nadal pasują do firmy

Nie musisz zgadywać, czy Twoja infrastruktura jest aktualna. Możemy to sprawdzić.

Oferuję darmową analizę, w ramach której:

- ocenimy wiek i stan Twojego sprzętu,

- sprawdzimy, jak są wykorzystywane zasoby (CPU, RAM, storage),

- porównamy aktualne potrzeby firmy z możliwościami infrastruktury,

- wskażemy, gdzie są wąskie gardła i jakie są ryzyka,

- zaproponujemy scenariusze modernizacji (lokalna, chmura, hybrydowa) z wyliczeniem TCO i ROI.

Jeśli Twoja firma korzysta z systemów ERP, MES, BMS, kontroli dostępu, czasu pracy lub innych systemów krytycznych dla biznesu – i nie pamiętasz, kiedy ostatnio ktoś sprawdzał, czy serwery jeszcze wystarczają – to dobry moment, żeby to zrobić.

Technologia poszła do przodu. Twoje serwery też powinny.